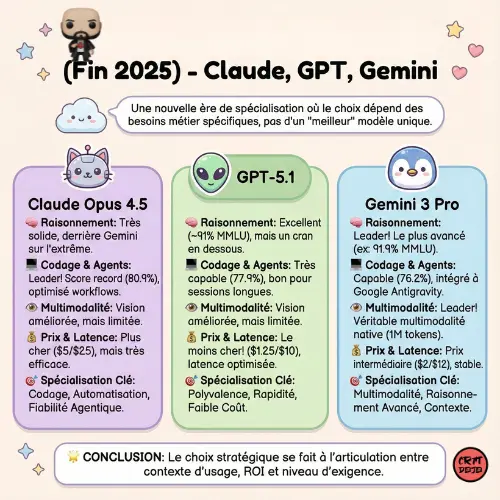

À l’automne 2025, l’intelligence artificielle a franchi un nouveau cap. OpenAI, Google DeepMind et Anthropic ont lancé successivement GPT-5.1, Gemini 3 Pro et Claude Opus 4.5, trois modèles de pointe qui redéfinissent les usages et les stratégies du secteur. Leur confrontation façonne non seulement la compétition technologique mais aussi les orientations stratégiques, les choix d’intégration métier, et le rapport coût/valeur pour les utilisateurs professionnels.

De quoi parle-t-on ? Un panorama des modèles

La libération quasi simultanée des trois modèles n’est pas anodine. Chacun vise à établir sa supériorité sur des segments cruciaux : raisonnement complexe, codage, agenticité, multimodalité et conversation. Cette course est nourrie autant par des benchmarks institutionnels que par les retours d’expérience des développeurs, chercheurs et entreprises.

Performances brutes : benchmarks et usages concrets

Raisonnement et connaissance

Les tests de connaissance (MMLU), de logique (Humanity’s Last Exam, ARC-AGI) et les compétitions en ligne montrent que Gemini 3 Pro s’impose comme le modèle le plus avancé en raisonnement complexe. Il obtient ainsi les meilleurs scores sur les épreuves extrêmes:

- Gemini 3 : 91,9% sur MMLU et jusqu’à 45% sur ARC-AGI en mode “Deep Think”

- GPT-5.1 : ~91% sur MMLU, un excellent résultat mais un cran en dessous sur les tests les plus difficiles (26.8% sur Humanity’s Last Exam)

- Claude Opus 4.5 : Très solide (estimé dans les 85–90%) mais moins performant que Gemini sur l’ultra-raisonnement

Cette domination sur la compréhension abstraite et les problématiques de logique donne à Gemini 3 un avantage pour des applications comme la recherche, l’analyse juridique, la synthèse multimodale de données ou la conception avancée.

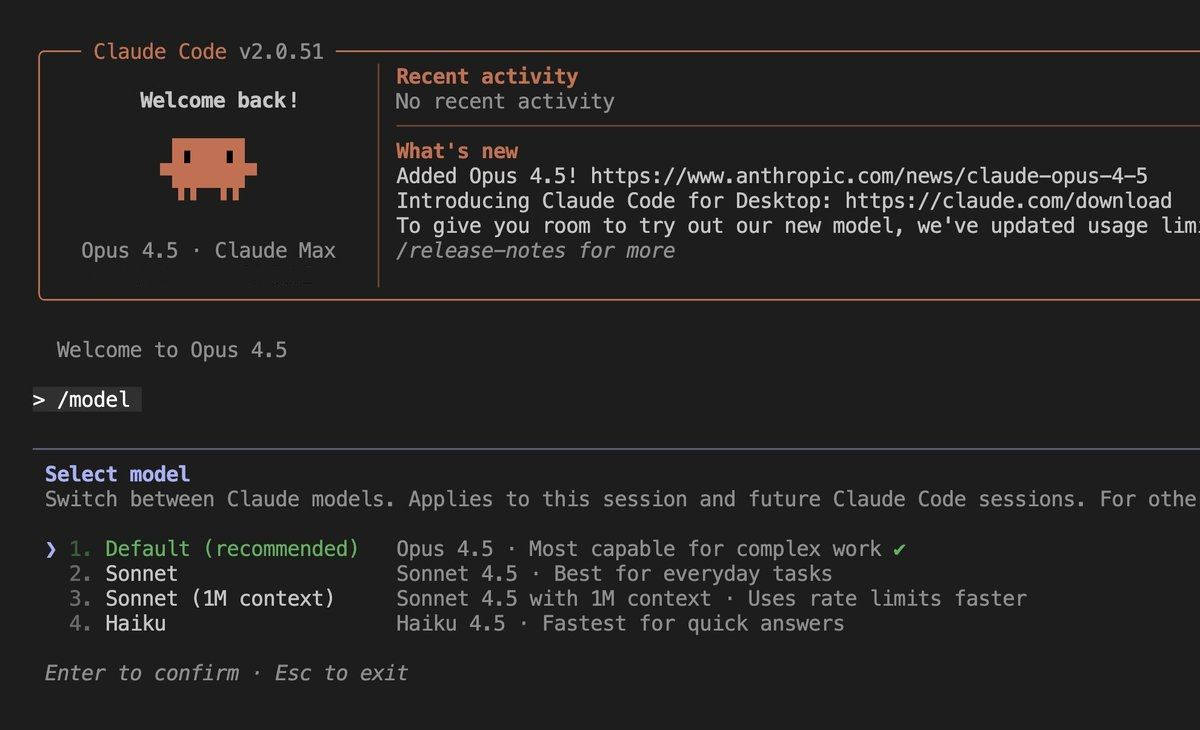

Codage, autonomie et agentique

Sur la programmation réelle, Claude Opus 4.5 prend la tête avec un score record (80,9% sur SWE-Bench Verified), notamment grâce à son optimisation pour les workflows agents et sa consommation minimale de tokens. GPT-5.1 (77,9%) et Gemini 3 (76,2%) suivent de près, et se montrent eux aussi capables de gérer des sessions longues, des refactorings et des automatisations complexes.

Claude 4.5 se distingue par :

- Son paramètre “effort” qui module la profondeur du raisonnement

- Sa mémoire contextuelle gigantesque (200 000 tokens)

- Des outils agentiques avancés (shell, navigateur, capture d’écran zoomée)

Gemini 3 tire profit de l’environnement Google Antigravity, qui l’intègre directement à l’éditeur, au terminal et au navigateur, rendant possibles des opérations logicielles de bout en bout, y compris avec inputs multimédias.

GPT-5.1, avec sa mode “Thinking”, innove dans la gestion adaptative de ses ressources cognitives, ce qui le rend polyvalent avec une latence optimisée pour les cas d’usage variés.

Capacités multimodales et gestion du contexte

Multimodalité native : la force de Gemini 3

Gemini 3 est le premier modèle à offrir une véritable multimodalité à une échelle inédite : jusqu’à 1 million de tokens, capable d’ingérer d’un coup du texte, des images, des vidéos, de l’audio et même des PDF pour synthétiser l’information. Cette prouesse technique ouvre le champ à des analyses complexes, du résumé vidéo à l’extraction de données documentaires, et positionne Gemini 3 en pointe pour la recherche, l’éducation, la compliance, ou l’analyse métier.

GPT-5.1 et Claude, bien qu’offrant aussi une vision améliorée, restent encore limités sur ce volet même si tous les trois promettent une mémoire contextuelle désormais “quasi illimitée” grâce à la compaction, au chainage ou à la présérvation des traces de pensée.

Passer à Google Workspace Business

• Code promo Business Starter: GA369TYLJNAFMTU (-10%)

• Code promo Business Standard: 66Q9AE7VPGH66WF (-10%)

Mémoire, personnalisation et adaptabilité

- Claude Opus 4.5 : 200 000 tokens, paramètre d’effort et prompts pour personnalisation

- GPT-5.1 : 128 000 tokens officiels, compaction dynamique pour sessions longues, presets de personnalité et instructions sur mesure

- Gemini 3 Pro : 1 million de tokens multimodal, personnalisation via prompts et paramètres de contexte

Une caractéristique marquante : aucune des plateformes ne propose aujourd’hui de “fine-tuning” modèle par l’utilisateur. Le réglage se fait par l’engineering de prompts et la modulation des paramètres internes, une évolution logique pour une IA de plus en plus orientée agent et usage métier.

Prix, latence et accessibilité : la guerre des usages

Tarification et efficacité

- GPT-5.1 : API la moins chère ($1.25/$10 par million de tokens), latence optimisée et accès via ChatGPT Plus/Enterprise

- Claude Opus 4.5 : prix abaissé mais encore double de GPT-5.1 ($5/$25) ; réduction forte du coût pratique grâce à l’efficacité en tokens

- Gemini 3 Pro : prix intermédiaire ($2/$12), supplément pour usage du contexte complet ; performance stable grâce à l’infrastructure Google

Comparaison synthétique Claude Opus 4.5, GPT-5.1 et Gemini 3 Pro :

Réalité utilisateur : retours, benchmarks et préférences

Les retours d’utilisateurs professionnels confirment le tableau des benchmarks, mais nuancent l’impact au quotidien :

- Claude Opus 4.5 est plébiscité par les développeurs pour refactoring massif, migrations de code et agenticité. Il est stable, prévisible, et résout les tâches complexes avec moins d’essais et de tokens.

- Gemini 3 Pro convainc sur la planification de tâches complexes, la recherche multimédia, et les workflows end-to-end nécessitant une intégration visuelle et logique.

- GPT-5.1 reste le favori des usages conversationnels, chatbots, agents transactionnels, et applications généralisées grâce à sa qualité de dialogue et son coût réduit.

Conséquences stratégiques pour le secteur et l’entreprise

Vers une polarisation fonctionnelle

La montée en puissance simultanée de ces trois modèles installe une dynamique de spécialisation :

- Claude 4.5 pour le codage, l’automatisation complexe et la fiabilité agentique

- Gemini 3 pour la multimodalité, le raisonnement avancé et l’analyse contextuelle

- GPT-5.1 pour la polyvalence conversationnelle, la rapidité et l’intégration à faible coût

Cette polarisation incite les entreprises à reconsidérer leur stack AI, en fonction des priorités métier : automatisation, data lineage, augmentation des agents de support, ou production de contenu multimédia.

Impact sur les stratégies d’intégration et la R&D

La bataille des contextes et du multitask entraîne une pression accrue sur le développement d’applications verticales, d’outils spécifiques à chaque modèle et sur la recherche en modularité, alignement et sécurité algorithmique. L’absence de fine-tuning direct pose une nouvelle frontière : l’ingénierie de prompt et la gestion de “mémoire conversationnelle” deviennent des compétences clés pour maximiser la valeur métier.

Conséquences macro : innovation, accessibilité et ROI

La baisse sensible des coûts et l’élargissement des capacités contextuelles rendent l’IA de pointe accessible à des startups, PME et ETIs. Le ROI s’ajuste à la capacité des modèles de réduire la latence, d’augmenter le taux d’automatisation, et de s’adapter à des inputs complexes, créant un cercle vertueux d’innovation.

Conclusion

En novembre 2025, la question n’est plus “quel modèle est le meilleur ?”, mais “quel modèle répond à quel besoin ?” :

- Claude Opus 4.5 s’impose auprès des développeurs et métiers cherchant efficacité et planification sur des tâches codées et agentiques.

- GPT-5.1 reste la référence généraliste pour la polyvalence, le chat, et les applications transactionnelles à grande échelle.

- Gemini 3 Pro occupe la place de leader sur la multimodalité et le raisonnement extrême, parfait pour la recherche et l’analyse de contenus riches.

Leur mise en concurrence accentue la démocratisation de l’IA, encourage l’innovation, et oblige les entreprises à revoir leur stratégie pour tirer parti d’un panel de solutions désormais moins limitées et beaucoup plus pointues.

Le choix, désormais, se fait à l’articulation entre contexte d’usage, ROI et niveau d’exigence en logique, codage ou multimodalité.

Chacun de ces modèles façonne le marché par ses priorités et le grand gagnant est, à terme, l’utilisateur professionnel, tant la pression de l’innovation abaisse les barrières à l’entrée et enrichit les possibilités d’intégration intelligente.